Introduction à la pensée critique

Cet article est probablement le plus fondamental de ceux que j’ai écrits jusqu’ici. Il fait une introduction aux principes fondamentaux de la pensée critique, à la rationalité et la méthode scientifique, qui sont cruciaux pour bien raisonner, comprendre le monde, décortiquer les affirmations et ne pas se faire manipuler.

La pensée critique, que je définis juste après, est non seulement utile pour réfléchir sur des sujets scientifiques, mais aussi politiques, sociétaux, etc. Elle est également un excellent outil dans le cadre de la foi, pour analyser avec une rigueur méthodique toute affirmation de ceux qui voudraient nous imposer leurs dogmes.

Table des matières :

- Définitions

- Réflexions préalables

- La faillibilité des sens et de l’esprit

- Les principes fondamentaux de la pensée critique

- L’adhésion évolutive

- Les niveaux de preuve

- Quelques outils méthodologiques

- Partir des faits

- Assurons-nous bien du fait, avant de nous inquiéter de la cause

- Distinguer précision et exactitude

- Logique de base

- Bien définir l’hypothèse testée

- Avoir des paramètres clairs, objectivables, quantifiables

- Comparer à un échantillon standard

- Partir de l’hypothèse nulle

- Faire un échantillonnage sans biais

- Répliquer les études

- Procéder en double ou triple aveugle

- Chercher à réfuter

- Quelques biais de raisonnement

- Ancrage

- Biais culturel

- Biais de confirmation

- Biais des couts irrécupérables

- Biais du survivant

- Biais d’attention

- Biais d’optimisme

- Biais d’équiprobabilité

- Biais rétrospectif

- Effet Barnum

- Effet Dunning-Kruger

- Effet de halo

- Effet Pangloss

- Effet de simple exposition

- Effet râteau

- Erreur fondamentale d’attribution

- Illusion de connaissance asymétrique

- Illusion de l’unique invulnérabilité

- Perception sélective

- Quelques arguments fallacieux

- Quelques outils pratiques

- S’entrainer

- Quelques ressources supplémentaires

- Références

Définitions

Avant de rentrer dans le coeur du sujet, précisons quelques termes centraux.

Pensée critique

Le concept de pensée critique n’est pas toujours clairement établi et son périmètre peut varier d’une considération à l’autre. On parle aussi parfois d’esprit critique.

Dans cet article, et en général, je me rattache à la définition donnée par Robert H. Ennis1, car elle est à la fois assez large tout en étant relativement exhaustive :

Pensée raisonnable et réflexive orientée vers une décision quant à ce qu’il faut croire ou faire.

Cette définition dégage plusieurs points importants :

- Raisonnable, donc conforme aux facultés intellectuelles ordonnées de jugement, de discernement, de compréhension, etc.2

- Réflexive, donc examinant en profondeur son sujet et étudiant ses propres mécanismes.3

- Orientée vers une décision, c’est-à-dire dont l’objectif n’est pas la pensée en elle-même.

Voici encore quelques autres définitions de la pensée critique, qui peuvent éclairer certains aspects.

Celle de Matthew Lipman4 :

Pensée qui facilite le jugement en s’appuyant sur des critères, en s’autocorrigeant et en étant perméable au contexte.

Celle de John E. McPeck5 :

Habileté et propension à s’engager dans une activité avec un scepticisme réflexif.

Nous préciserons tout cela et verrons ce que ça implique dans la suite de cet article.

Rationalité

La rationalité peut être définie simplement comme étant6 :

Le caractère de ce qui est conforme à la raison.

Ou, comme le définit Eliezer Yudkowsky7 :

La rationalité est l’art de penser de manière à produire des croyances précises et prendre de bonnes décisions.

On peut ainsi distinguer deux concepts de rationalité :

- La rationalité épistémique : améliorer systématiquement la précision et l’exactitude de ses croyances

- La rationalité instrumentale : atteindre systématiquement ses objectifs

Note : ici le mot systématiquement signifie avec systématisme, avec méthode.

La rationalité épistémique est la recherche systématique de la vérité, c’est-à-dire la construction de schémas mentaux qui correspondent le plus possible à la réalité.

La rationalité instrumentale est l’accomplissement systématique de ses objectifs, c’est-à-dire le choix des actions qui mènent aux conséquences désirées.

La pensée critique est donc une démarche rationnelle, au sens épistémique comme instrumental.

NB : il ne faut pas confondre la rationalité avec le rationalisme, qui est une doctrine philosophique selon laquelle la raison seule suffirait à produire des connaissances certaines, par opposition à l’empirisme qui prône l’acquisition des connaissances via l’observation et l’expérience.

Scepticisme scientifique

La notion de scepticisme scientifique ou scepticisme rationnel peut être définie comme suit8 :

Position épistémologique et attitude de doute raisonnable vis-à-vis des allégations non étayées par des preuves empiriques.

Il s’agit donc d’une posture de doute à priori, s’appuyant sur la pensée critique et la méthode zététique. On peut dire que le scepticisme scientifique est donc un choix rationnel, au sens épistémique comme instrumental.

Zététique

Un terme fortement lié au concept de pensée critique est celui de zététique. Le mot vient du grec ζητητικός (zētētikós) qui signifie “qui aime chercher”.

Aujourd’hui, le terme désigne “l’art du doute”. Comme le dit Richard Monvoisin9 :

Le terme zététique, au sens moderne, désigne la méthode, la démarche critique proprement dite, là où le scepticisme offre la posture épistémologique. D’une manière un peu simpliste, nous tendons à dire que le scepticisme est la posture philosophique dont la zététique est le bras outillé.

Et il précise également :

Ainsi le terme moderne zététique revêt-il désormais deux aspects :

- l’un fonctionnel : elle est la démarche scientifique d’investigation des phénomènes extraordinaires, des prétentions étranges et des théories discutables, analysées selon un scepticisme méthodologique ouvert et une philosophie rationaliste matérialiste.

- l’un didactique : elle est la panoplie de tous les moyens intellectuels mis en œuvre pour amener l’apprenant à développer l’esprit critique vis-à-vis de toute thèse de type scientifique.

Ainsi, la zététique est donc l’ensemble des méthodes d’investigation de la pensée critique.

Science

Le mot science désigne parfois des concepts qui ne sont pas pertinents dans notre contexte. Il peut par exemple désigner l’ensemble des connaissances, la communauté scientifique, l’usage politique de la science, etc.

Dans le cadre de cet article, je donne cette définition :

Démarche intellectuelle structurée visant à produire des affirmations objectivables s’approchant le plus possible de la réalité.

Réflexions préalables

Raison vs émotions

Il existe un mythe tenace selon lequel raison et émotions seraient opposées, ou encore que plus une personne serait rationnelle plus elle serait privée d’émotions, froides, calculatrice et incapable d’être créative ou d’apprécier la beauté.

Est-ce légitime d’opposer émotions, créativité et spontanéité à rationalité ? D’opposer scientifique à artiste ? D’associer rigueur de pensée avec rigidité de caractère ?

Il existe pourtant de nombreux exemples de personnes qui montrent le contraire. Citons par exemple :

- Léonard de Vinci, peintre, sculpteur, architecte, philosophe, ingénieur, organisateur de fêtes10, poète, musicien, botaniste, etc.

- Beatrix Potter, écrivaine et naturaliste11

- Samuel Morse, ingénieur et peintre12

- Hedy Lamarr, actrice de cinéma et inventrice13

- Brian May, musicien, chanteur, compositeur et astrophysicien14

Nous sommes, bien heureusement, capables de changer de mode de pensée selon les situations et même de combiner plusieurs modes de pensée (par exemple quand on écrit de la fiction : créativité des dialogues et du style avec rigueur des règles de la langue et cohérence de l’histoire).

En outre, d’un point de vue scientifique, les émotions sont des états biologiques associés au système nerveux15 16 17 provoqués par des déclencheurs neurophysiologiques18 19 associés à des pensées, des sentiments, des réponses comportementales, etc. Elles sont donc provoquées par des éléments réels et peuvent être une source d’information utile pour une prise de décision.20

Les émotions sont certes une grande source de biais cognitifs, mais peuvent aussi être utilisées lors d’une réflexion. Comment le disent Alan Kirman, Pierre Livet et Miriam Teschl21 :

Les résultats de recherches psychologiques et neurologiques montrent que les émotions et les états affectifs ne sont pas seulement des sources de jugements biaisés, mais peuvent également servir de fonctions essentielles conduisant à des choix plus appropriés.

Cependant les émotions ne sont pas des reflets fiables de la réalité, sont facilement manipulables et peuvent induire une persévérance à long terme dans de mauvaises décisions.22

En résumé, émotions et rationalité ne s’opposent pas. Les émotions peuvent être des indices à utiliser avec parcimonie lors d’un processus de réflexion.

Trop rationnel ?

J’ai souvent entendu des remarques comme : “il ne faut pas être trop rationnel, sinon tu ne peux plus t’émerveiller” ou “il ne faut pas être trop rationnel, tout vouloir calculer plutôt que de suivre son instinct, sinon tu rates des opportunités”, etc.

Que peut-on y répondre ? C’est très simple !

Si mon objectif est de pouvoir être émerveillé, par exemple par un film ou un spectacle de prestidigitation, alors il est parfaitement rationnel (au sens instrumental) de ne pas chercher à comprendre les trucages et effets spéciaux.

De même, si mon objectif est de saisir des opportunités, il peut être parfaitement rationnel de suivre son instinct. Être rationnel c’est aussi utiliser le mode de pensée le plus adapté à la situation.

Rappelons-nous toujours les deux concepts de rationalité :

- La rationalité épistémique : améliorer systématiquement la précision de ses croyances

- La rationalité instrumentale : atteindre systématiquement ses objectifs

Idées fausses sur la rationalité

Je réfute ici brièvement cinq idées fausses couramment exprimées à propos de la rationalité, deux desquelles ont été abordées juste avant.

1. Être rationnel c’est s’attendre à ce que les autres soient rationnels

Être rationnel c’est avoir un modèle représentant le réel le plus fidèlement possible, avoir une idée la plus vraie possible de ce qui est. Or si en réalité tout le monde n’est pas rationnel, ou l’est à différents degrés, il est rationnel d’adapter notre représentation du monde en conséquence.

2. Être rationnel signifie ne jamais prendre de décision avant d’avoir toutes les informations

Encore une fois, agir de façon rationnelle c’est maximiser nos chances d’atteindre nos objectifs. Or si notre objectif est d’accomplir une tâche de manière efficace (dans les délais, sans rater d’opportunités, etc.) il peut être rationnel de prendre des risques et d’avancer avant d’avoir tous les éléments. Être rationnel, c’est ne pas se limiter à considérer les informations, mais aussi les risques, le temps, les conséquences, etc.

Voici un exemple d’illustration donné par le psychologue Gerd Gigerenzer23 :

Imaginez un homme [se réclamant de cette fausse rationalité] essayant de trouver une femme à épouser. Il devrait examiner les probabilités des diverses conséquences du mariage avec chacune d’elles. Après de nombreuses années de recherche, il découvrirait probablement son choix final. Mais elle aura déjà épousé un autre homme, qui n’a pas fait ces calculs et en est tombé amoureux.

Dans cet exemple, attendre d’avoir toutes les informations est clairement contreproductif au regard de l’objectif, c’est-à-dire irrationnel.

3. Être rationnel signifie ne jamais se fier à l’intuition

On peut distinguer deux “modes de fonctionnement” du cerveau, appelés système 1 et système 2 (ou parfois système implicite et système explicite)24 25 :

Le système 1, intuitif, nous permet de faire des jugements rapides et automatiques en utilisant des raccourcis (c’est-à-dire des euristiques) qui sont généralement bons la plupart du temps, tout en nécessitant très peu de temps et d’attention.

Le système 2, délibératif, nous permet de faire des choses comme le raisonnement abstrait et la pensée hypothétique et de créer des modèles qui expliquent des évènements inattendus. Le système 2 a tendance à faire mieux lorsque vous avez plus de ressources et plus de temps et pire lorsque vous disposez de peu de temps.

Les deux systèmes se disputent le contrôle de nos inférences et de nos actions.

Voici une expérience réalisée par Shane Frederick qui illustre ces deux systèmes26. Il pose une série de trois questions ayant une réponse issue du système 1, fausse, “qui vient immédiatement à l’esprit” et une autre issue du système 2, juste, qui nécessite quelques instants de réflexion :

- Une batte et une balle coutent 1,10 $ au total. La batte coute 1,00 $ de plus que la balle. Combien coute la balle ?

- S’il faut à 5 machines 5 minutes pour créer 5 produits, combien de temps faudrait-il à 100 machines pour créer 100 produits ?

- Sur un lac il y a une zone de nénufars. Chaque jour, la zone double de taille. S’il faut 48 jours pour que la zone couvre tout le lac, combien de temps faudrait-il pour qu’elle recouvre la moitié du lac ?

Les réponses issues du système 1, fausses, sont :

- 0,10 $

- 100 minutes

- 24 jours

Les réponses issues du système 2, correctes, sont :

- 0,05 $

- 5 minutes

- 47 jours

Ainsi, comme le résume Julia Galef27 :

Notre système 1 est sujet aux biais, et il est également incroyablement puissant. Notre intuition a tendance à bien faire avec les décisions d’achat ou d’autres choix concernant notre vie personnelle. Le système 1 est également très puissant pour un expert. Les grands maitres d’échecs peuvent jeter un coup d’œil sur un échiquier et dire “échec et mat en trois coups”, à cause du temps et des efforts mentaux consacrés à jouer aux échecs et à construire une base de connaissances mentales à ce sujet.

L’intuition peut être mauvaise et moins fiable lorsqu’elle est basée sur quelque chose qui n’est pas pertinent pour la tâche à accomplir ou lorsque vous ne disposez pas de connaissances spécialisées sur le sujet.

La principale chose à retenir est que les deux systèmes ont des forces et des faiblesses, et que la rationalité consiste à trouver le meilleur chemin — en utilisant les deux systèmes au bon moment — vers la rationalité épistémique et instrumentale.

4. Être rationnel signifie ne pas avoir d’émotions

Tout d’abord, comme l’explique Julia Galef27 :

Les émotions sont nécessaires pour établir nos objectifs, la rationalité n’a aucune valeur normative sans elles.

En effet, atteindre nos objectifs efficacement suppose que nous ayons des objectifs. Et ceux-ci sont subjectifs.

De plus, comme vu précédemment, il est absolument possible de choisir d’être émotif ou non, et à différents degrés, selon les situations. En outre les émotions sont provoquées par des éléments du réel15 16 17 18 19 et peuvent être utiles, dans une certaine mesure, à une prise de décision plus efficace. 20

Seulement, les émotions conduisent souvent à des biais cognitifs et il faut donc s’en méfier lorsque nous voulons effectuer un raisonnement. Je cite encore Julia Galef à ce sujet27 :

Comment les émotions nous rendent-elles irrationnelles ? Les émotions peuvent être épistémiquement irrationnelles si elles sont basées sur un faux modèle du monde. Les émotions peuvent être instrumentalement irrationnelles si elles nous empêchent d’atteindre nos objectifs.

Il faut aussi se rappeler que les émotions peuvent causer des biais émotionnels qui induisent une déformation des connaissances et parasitent les processus de décision.28 29 30

5. Être rationnel signifie ne valoriser que des choses quantifiables, comme l’argent, l’efficacité ou la productivité

Au regard de la rationalité épistémique, valoriser quelque chose n’a pas de sens. Il s’agit de décrire le réel avec le plus de précision possible, pas de faire des jugements de valeur.

Au regard de la rationalité instrumentale, tout dépend des objectifs qu’on s’est fixés. Si notre objectif est d’avoir une vie heureuse et pleine de découvertes artistiques, alors rechercher le bonheur et apprécier l’esthétique seront rationnels.

Synthèse

Je cite Julia Galef27 :

Si vous pensez que vous agissez de manière rationnelle, mais que vous continuez à obtenir la mauvaise réponse, et que vous finissez toujours plus mal que vous ne pourriez l’être, alors la conclusion que vous devriez en tirer n’est pas que la rationalité est mauvaise, c’est que vous êtes mauvais à la rationalité.

En d’autres termes, vous vous trompez !

Champs d’application

Il est important de noter que la pensée critique s’applique et ne peut s’appliquer que sur ce qui relève de l’adhésion.

Comme le dit Richard Monvoisin9 :

Il faut distinguer entre la croyance comme acte de foi (faith) et la croyance de type adhésion (belief).

L’adhésion est donc, par opposition à la foi9 :

Une croyance produite par une démarche d’énonciation de vérité susceptible d’être infléchie par le raisonnement ou l’expérience.

Par exemple, la croyance en Dieu relève de la foi (et se place donc hors du champ de la pensée critique) si elle n’est basée sur aucun élément tangible, et de l’adhésion dans le cas contraire. Si quelqu’un dit “je crois en Dieu par acte de foi”, la pensée critique ne peut pas s’y appliquer, mais s’il dit “je crois en Dieu, car sans Dieu il n’y aurait pas de morale” ou “je crois en Dieu, car il faut bien que l’Univers ait une cause”, la pensée critique peut s’y appliquer.

Voici quelques exemples d’énoncés relevant de la foi :

- Je n’aime pas Manuels Valls

- Dieu existe

- Le jazz c’est mieux que la musique classique

- Les yaourts c’est bon

Et d’autres, relevant de l’adhésion :

- Écouter du jazz c’est mieux que de la musique classique car ça rend plus intelligent

- Manger des yaourts fait grandir

- Le Suaire de Turin date du premier siècle

- Le Doliprane est efficace contre les maux de tête

Pourquoi être rationnel ?

Richard Monvoisin résume la situation ainsi9 :

La science n’est pas la seule manière d’investiguer le réel. Effectivement, tout un chacun a la possibilité de s’en remettre à l’introspection, à la lecture de Révélations, à l’art à la méditation ou à la gamme des mancies pour choisir et décider.

La science, bien moins trépidante à première vue, a ceci d’intéressant qu’elle est construite pour être la « manière efficace » de décrire le réel. Tout y est fait pour éviter les biais subjectifs, et pour que les descriptions soient assorties de tous les bémols possibles, de l’écart type des résultats à la fiabilité, leur reproductibilité, etc.

Il ne faut pas compter sur la science pour vous dire ce qui est « beau » dans une toile de Modigliani, ou pour apprécier la lecture des Chants de Maldoror. Par contre, si l’on veut savoir si quelque chose « marche », fonctionne, est efficace ou assure le plus de chances de réussite, la science est tout simplement faite pour ça.

Si donc notre objectif est d’atteindre nos objectifs au mieux, alors il est utile d’être rationnel au sens instrumental. Or pour cela nous nous basons sur un modèle de la réalité qui ne peut être rendu plus précis qu’en étant rationnel au sens épistémique.

La rationalité n’est pas une vertu ou un impératif moral, c’est une manière de penser qui nous permet de connaitre le réel avec plus de précision et de mieux réaliser nos objectifs.

Pour en savoir plus, visionnez l’excellente vidéo de Christophe Michel sur le sujet :

Intelligence et rationalité

Sans rentrer dans les détails, je vais éclaircir une confusion courante entre intelligence et rationalité. Être intelligent n’est pas être rationnel, et inversement. D’ailleurs, intelligence et rationalité sont très peu corrélées.31

Je reprends ici une métaphore proposée par Thomas Durand32 :

Être intelligent c’est avoir un gros moteur, être rationnel c’est avoir un bon frein, un bon volant.

Beaucoup de gens sont intelligents, peu sont rationnels. Et beaucoup de gens très intelligents croient des choses sans fondement, et dans leur domaine de compétence cela ne leur pose aucun problème.

En effet, beaucoup de champs spécialisés sont comme une piste de course en ligne droite. Ces gens avec de très gros moteurs peuvent franchir la ligne d’arrivée très vite. Qu’ils soient rationnels ou non n’a que peu d’importance puisqu’ils n’ont pas besoin de prendre de virages.

Seulement la vie n’est pas une piste droite, mais une route tortueuse avec de nombreux virages et embranchements. Être rationnel c’est être en mesure de négocier ces virages, de choisir les bons embranchements, etc.

C’est également pour cette raison qu’il faut se méfier des gens intelligents et non rationnels, car quand ils se plantent, ils se plantent plus fort.32

Attitude

Avant de nous plonger dans les méthodes de la pensée critique, je voudrais préciser quelques points sur l’attitude à avoir dans cette démarche :

- Nous avons peut-être un avis sur tout, mais réellement une expertise sur très peu de choses. En l’absence de données suffisantes, il est bon d’admettre notre ignorance et de suspendre notre jugement.

- Rien n’est vrai que jusqu’à preuve du contraire. Soyons prêts à faire évoluer nos convictions en cas d’émergence de nouveaux éléments probants.

- Le réel existe tel qu’il est, qu’il nous plaise ou non. Soyons honnêtes dans nos démarches épistémiques.

- La pensée critique et la démarche zététique ne sont pas prescriptives, mais informatives. Nous restons parfaitement libres de nos choix, qu’ils soient rationnels ou non.

- Avant de se lancer dans un débat, il peut être utile de demander à son interlocuteur s’il y a un élément qui pourrait le faire changer d’avis. Si la réponse est non alors il est dans un système de croyance par pure foi et un débat est probablement inutile. De même, si la théorie qu’il défend a été construite avant de chercher les faits pour la soutenir, alors c’est mauvais signe et il est fort probable qu’il soit là aussi, au moins en partie, dans un système de croyance par pure foi.

La faillibilité des sens et de l’esprit

“C’est vrai, je l’ai vu de mes propres yeux !” et “C’est vrai, je m’en rappelle très bien !” sont deux affirmations à prendre avec des pincettes quand on sait à quel point nos sens et notre mémoire peuvent être faillibles, même en fonctionnement “standard” (sans altération par un handicap, une maladie, une substance, etc.).

Dans cette section, je vais brièvement parler de la faillibilité de nos sens et de notre mémoire et donner quelques exemples.

La faillibilité des sens

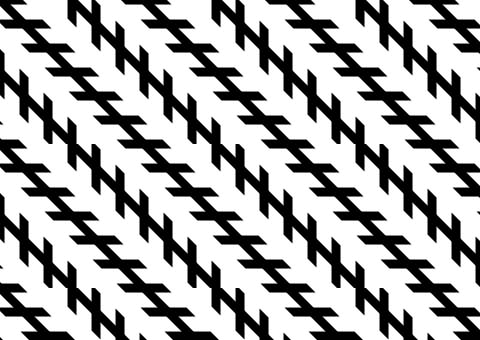

Les illusions visuelles

Les illusions visuelles sont des perceptions visuelles s’opposant à la réalité. Elles peuvent être :

- Physiques : la perception est faussée par un élément physique, par exemple une forte chaleur ou une faible humidité, qui dévie les rayons lumineux.

- Physiologiques : la perception est faussée par un effet du corps, comme pour les images rémanentes (quand la sensation visuelle persiste après la disparition du stimulus).

- Cognitives : la perception est faussée par une mauvaise interprétation de l’image.

Exemple d’illusion visuelle physiologique

Fixez le point noir dans l’oeil du Che Guevara dans l’image ci-dessous pendant une trentaine de secondes puis fermez les yeux. Vous voyes l’image persister (le noir étant devenu blanc et inversement).

Exemples d’illusions visuelles cognitives

Les voitures ci-dessous font la même taille :

Regardez plutôt :

Les carrés A et B ont la même couleur :

Les droites sont parallèles :

Dans cette vidéo, la danseuse peut tourner dans un sens ou dans l’autre selon le point sur lequel vous vous concentrez :

Pour voir quelques autres illusions, visionnez cette excellente publicité Honda de 2013 :

Il y a également un type particulier d’illusion visuelle, la paréidolie, qui consiste à identifier une forme familière à un stimulus informe ou sans rapport objectif, par exemple à reconnaitre une forme humaine ou animale, voir même une émotion, dans des objets :

Les illusions auditives

Les illusions auditives sont des perceptions auditives s’opposant à la réalité. Ni les hallucinations auditives, qui ne se rapportent à aucun son, ni les acouphènes, qui sont un symptôme d’une défaillance du système auditif, ne sont des illusions auditives.

Dans cette vidéo, on entend “ba” ou “fa” selon l’image affichée alors que le son est le même (effet McGurk) :

Dans ce sketch, l’humoriste Serge Llado présente différentes chansons en langues étrangères en suggérant des paroles françaises faitaisistes au préalable. Il est alors difficile d’entendre autre chose. Il parle d’hallucination auditive, mais le terme exact est paréidolie auditive :

Dans cet autre exemple, on entend soit Yanny soit Laurel en fonction de la fréquence perçue :

La surcharge cognitive

C’est quand notre cerveau a trop d’informations à gérer.

Regardez quelques images d’une campagne de publicité Colgate :

Sur mobile, vous pouvez orienter votre appareil en paysage.

Vous avez remarqué les restes de nourriture coincés entre les dents des hommes ? Bien sûr ! On le remarque tout de suite. Mais avez-vous remarqué que sur la première image il manque une oreille à l’homme, que sur la seconde la femme a un troisième bras et que sur la dernière elle a un sixième doigt ?

Un phénomène similaire est à jeu dans l’effet Stroop (interférences d’informations non pertinentes).

Essayez de dire la couleur des mots suivants :

Enfin, regardez la vidéo suivante. Serez-vous être suffisamment attentifs ?

Les illusions tactiles

Au même titre que les illusions visuelles et auditives, on trouve aussi des illusions tactiles. Par exemple :

- Le lapin qui saute33 34 35, dans laquelle on tapote rapidement une personne à deux endroits différents (par exemple le coude et le poignet), et qui donne l’illusion d’être touché à plusieurs endroits entre ces deux zones.

- L’effet Tau36 37, lorsque des participants jugent la distance spatiale entre plusieurs tapotements distincts comme étant irrégulière alors que seul le rythme varie.

- En mangeant, si une personne tient un aliment avec une texture et une autre texture est présentée à la bouche, de nombreuses personnes perçoivent le croustillant de l’aliment comme étant entre les deux textures.38

- En touchant certains objets à la forme visuellement trompeuse, on peut ressentir un trou à la place d’une bosse.39

La faillibilité de l’esprit

L’effet de cadrage

C’est présenter des informations d’une manière orientée sans en changer le sens exact (parler d’un “verre à moitié plein” plutôt qu’un “verre à moitié vide”).

Dans une série d’expériences en 1981, Amos Tversky et Daniel Kahneman ont posé une série de questions à plusieurs centaines de participants pour décrire cet effet40. En voici un exemple :

Version 1 :

Vous avez 600 patients atteints d’une maladie mortelle.

- Avec un traitement A, 200 seront sauvés.

- Avec un traitement B, il y a 1 chance sur 3 de sauver les 600, et 2 chances sur 3 de n’en sauver aucun.

Quel traitement choisissez-vous ?

Version 2 :

Vous avez 600 patients atteints d’une maladie mortelle.

- Avec un traitement A, 400 mourront.

- Avec un traitement B, il y a 1 chance sur 3 qu’aucun ne meurt, et 2 chances sur 3 que les 600 meurent.

Quel traitement choisissez-vous ?

Les deux versions des questions donnent exactement les mêmes informations quant à l’efficacité et aux conséquences des deux traitements. Voici les résultats :

- Version 1 : 72% choisissent la première réponse.

- Version 2 : 78% choisissent la deuxième réponse.

D’autres questions du même type ou portant sur la manière de présenter les gains et les risques sont présentés dans leur article The framing of decisions and the psychology of choice.

Une autre illustration de l’effet de cadrage se retrouve dans cet excellent exemple pédagogique :

L’effet impact

C’est quand on utilise la connotation des mots pour induire une idée différente de ce que ces mots prétendent représenter.

En 2005 Richard Wiseman et Emma Greening ont réalisé une expérience41 impliquant 50 étudiants sur le campus de l’université de Hertfordshire au Royaume-Uni. Ils ont montré aux participants une vidéo d’un illusionniste tordant “par la pensée” une clé posée dans la paume de sa main, puis la posant sur une table devant lui. Le phénomène a été présenté aux étudiants comme étant paranormal.

Les étudiants devaient répondre à la question “Une fois posée sur la table, la clé a-t-elle continué de se tordre ?” (la bonne réponse étant “non”).

Les étudiants étaient répartis aléatoirement en deux groupes isolés. Pour le second groupe, la vidéo contenait une séquence supplémentaire au début où l’illusionniste suggérait (à tord) que la clé continuerait de se tordre une fois posée.

Les résultats à la question pour les deux groupes sont :

| Groupe 1 | Groupe 2 | |

|---|---|---|

| La torsion continue | 4% | 40% |

| La torsion ne continue pas | 96% | 60% |

L’expérience a été répétée, avec d’autres participants. Cette fois la question demandait simplement “décrivez ce qui s’est passé”, sans mentionner le fait que la clé pouvait continuer de se tordre. Voici les résultats :

| Groupe 1 | Groupe 2 | |

|---|---|---|

| La torsion continue | 0% | 36% |

| La torsion ne continue pas | 100% | 64% |

Cela illustre bien la puissance de cet effet ! Il peut même avoir une influence si importante qu’on observe par exemple des effets physiologiques sur des patients en employant un mot plutôt qu’un autre lors du diagnostic.42

Les faux souvenirs

Chez tous les individus, même parfaitement sains, la mémoire est faillible, malléable.

La mémoire est constituée de plusieurs registres43 44 et stocke les informations de manière discontinue.45 Il est par exemple difficile de réciter l’alphabet à l’envers en l’ayant appris uniquement à l’endroit. Essayez pour voir : Z… Y… X…

Mais cela va bien plus loin.

Dans une expérience en 197946, Dedre Gentner et Elizabeth Loftus ont présenté aux participants une série d’images accompagnées de légendes aux verbes génériques (par exemple “walk”, marcher) pour le groupe 1 et spécifiques (par exemple “hike”, randonner) pour le groupe 2.

Une semaine plus tard, ils leur ont montré une autre série d’images, contenant certaines des images de la première fois, de nouvelles images totalement différentes et certaines nouvelles, mais dont le thème était le même que certaines de la première série. Ils leur ont demandé d’indiquer celles dont ils se souvenaient avec certitude.

36% ont indiqué se rappeler d’une image alors qu’elle ne leur avait pas été présentée, mais dont le thème était le même. Cette proportion atteignait 47% quand les images de la première semaine étaient accompagnées de légendes avec des verbes spécifiques.

D’autres expériences du même genre ont par exemple fait se “souvenir” à des étudiants la présence de certains objets lors d’un cours alors que seules des questions mentionnant ces objets y avaient été posées47, intégré de faux éléments par suggestion dans le souvenir d’un accident48, fait accepter des affirmations contradictoires par l’introduction de faux souvenirs au moment opportun49, créé le faux souvenir d’une peur intense50, etc.

D’autres études51 52 53 54 55 56 57 58 59 60 61 ont conduit de nombreuses expériences similaires et indiquent toutes que les souvenirs peuvent êtres modifiés, créés ou supprimés et que la mémoire n’est pas un témoin fiable.

Récapitulatif

Nos sens et notre mémoire ne sont pas fiables à 100%, loin de là. Ils ne consistuent donc pas des preuves fiables. Ainsi, sans remettre en cause la sincérité de quiconque, aucun témoignage ne peut être accepté comme preuve (au sens scientifique, pas juridique).

Les principes fondamentaux de la pensée critique

Retrouvez un résumé de cette section ici : [En bref] Principes fondamentaux de la pensée critique

Voici quelques-uns des principes fondamentaux de la pensée critique. Ils servent de fondation à une réflexion plus poussée et priorisant les hypothèses les plus probables, en éliminant les arguments non pertinents d’un point de vue épistémique, etc.

Je les présente sommairement, sans détailler toutes leurs nuances et leur complexité, mais nous les verrons un peu plus en détail dans la suite de l’article.

Le Rasoir d’Hitchens

Ce qui peut être affirmé sans preuve peut être rejeté sans preuve.

Si quelqu’un m’affirme “les licornes existent” sans apporter le moindre élément de preuve, je n’ai aucune raison de croire plus à leur existence qu’avant d’entendre ces propos.

Attention, il ne s’agit pas de pouvoir affirmer le contraire de l’affirmation. Si quelqu’un m’affirme “les licornes existent” sans apporter le moindre élément de preuve, le Rasoir d’Hitchens ne me permet pas d’affirmer “les licornes n’existent pas” sans preuve, bien que je puisse privilégier cette hypothèse (cf. le principe de parcimonie des hypothèses).

Le Rasoir d’Hitchens est fortement lié à l’onus probandi.

L’onus probandi

La charge de la preuve incombe à celui qui prétend.

Comme l’expliquent Richard Monvoisin et Nicolas Pinsault62 :

C’est à celui qui prétend quelque chose de le prouver et non aux autres de prouver que ce qu’il prétend n’est pas vrai.

Ce n’est pas aux critiques de Claude Vorilhon, alias Raël de prouver qu’il n’a pas pu être enlevé par des extraterrestres, mais bien à lui de démontrer qu’il l’a été. De la même façon, ce n’est pas aux critiques d’une technique de montrer qu’elle est inefficace, mais bien aux prétendants de montrer qu’elle possède l’efficacité que ceux-ci lui prêtent.

Imaginons le bazar s’il fallait prendre pour vraie toute affirmation, par exemple sur un médicament, et devoir attendre que quelqu’un montre qu’elle est fausse pour y renoncer. Tout vendeur de potions pourrait rétorquer à vos doutes : “prouvez donc que ma potion n’est pas miraculeuse”.

Il est de toute façon logiquement impossible de montrer que quelque chose n’existe pas.

Le principe de parcimonie des hypothèses (ou Rasoir d’Ockham)

Les hypothèses suffisantes les plus parcimonieuses doivent être préférées.

Il s’agit, entre plusieurs hypothèses au même pouvoir explicatif, de privilégier celle qui est la plus parcimonieuse, celle qui est la moins couteuse cognitivement, celle qui fait appel au moins d’autres hypothèses non démontrées.

Cela implique que face à un phénomène encore inexpliqué, on tentera d’abord de l’expliquer à partir de ce qui est connu avant de postuler l’existence de quelque chose d’inconnu. Ou que face à trois symptômes simultanés on recherche d’abord une maladie pouvant causer ces trois symptômes plutôt que trois maladies causant chacune un symptôme.

Richard Monvoisin en donne un exemple9 :

Je mets un chat et une souris dans une boite, je ferme, je secoue, et j’ouvre : il ne reste plus que le chat.

- Hypothèse 1 : des extraterrestres de la planète Mû ont voulu désintégrer la souris, mais elle s’est transformée en chat. Le chat, de frayeur, est passé dans une autre dimension par effet Tunnel.

- Hypothèse 2 : le chat a mangé la souris.

Vous m’accorderez que l’hypothèse 2 est beaucoup moins couteuse intellectuellement que la N°1. Elle ne postule rien d’autre que la prédation de la souris par le chat, tandis que la première postule une planète Mû, des extraterrestres qui viennent, qui savent désintégrer un chat ce qui n’est pas donné à tout le monde, une souris qui se transforme en chat, une autre dimension, un chat qui sait y aller et un effet tunnel pour objet macroscopique. Ça fait beaucoup. Dans le doute, on choisira la 2.

Attention, il ne s’agit pas de dire que l’hypothèse parcimonieuse est vraie. En l’absence de preuve, nous ne pouvons être surs de rien. Il s’agit seulement de dire qu’il est plus sage, plus rationnel de privilégier celle-ci jusqu’à l’apparition éventuelle de nouveaux éléments probants.

Le critère de réfutabilité

Une proposition n’est recevable que si elle est réfutable.

Une proposition est réfutable s’il existe un énoncé qui lui est contradictoire, c’est-à-dire qui la falsifierait s’il se révélait vrai. Par exemple la proposition “tous les cygnes sont blancs” est réfutable, car il suffirait de trouver un cygne qui ne soit pas blanc pour l’infirmer.

Si une proposition n’est pas réfutable, alors elle n’a aucune valeur probante et n’est pas rationnelle.

L’adhésion évolutive

Le concept d’adhésion évolutive est un élément extrêmement important de la pensée critique, qu’on utilise tous intuitivement, plus ou moins consciemment, avec plus ou moins de rigueur.

Afin de comprendre ce que c’est et comment l’utiliser, je vais d’abord parler d’inférence bayésienne, le mécanisme probabiliste sur lequel repose l’adhésion évolutive, puis de curseurs de croyance qui sont un représentation mentale de ce mécanisme, bien plus simple et plus pratique dans la vie de tous les jours.

L’inférence bayésienne

Cette section comporte un peu de maths, mais rien de bien compliqué. Elle est sans doute un peu plus rude à aborder que le reste de l’article mais elle est fondamentale. Je vous encourage donc fortement à la lire avec attention.

Tout d’abord, qu’est-ce qu’une inférence ?

C’est63 :

Une opération logique par laquelle on admet une proposition en vertu de sa liaison avec d’autres propositions déjà tenues pour vraies.

Il existe deux approches, celle plus simple et courante, fréquentiste, et celle un peu plus complexe et moins courante, bayésienne.

- L’inférence fréquentiste c’est déterminer la probabilité des faits en fonction des hypothèses.

- L’inférence bayésienne c’est déterminer la probabilité des hypothèses en fonction des faits.

En gros, l’inférence fréquentiste détermine \(P(x \vert H)\) la vraisemblance des résultats x dans le carde de l’hypothèse H, et l’inférence bayésienne détermine \(P(H \vert x)\) la plausibilité de l’hypothèse H au vu des résultats x.

Note : \(P(A \vert B)\) se lit probabilité de A sachant B.

Illustrons les deux méthodes par un exemple.

Imaginons que j’ai plusieurs dés avec un nombre de faces différents (par ex. 4, 6, 8, 10, 12 et 20).

Je prends un dé à 8 faces, je le lance 3 fois à j’obtiens 7 à chaque fois. Est-ce extraordinaire ?

Avant de pouvoir répondre à cette question, nous devont nous mettre d’accord sur ce qui constitue une série de lancers extraordinaire. Disons que c’est toute série qu’on a moins de 1% de chances d’obtenir par hasard. Notez que j’ai choisi 1% de manière arbitraire et qu’on aurait très bien pu choisir 2% ou 0,1%.

Notons \(D_n\) l’utilisation d’un dé à n faces (par exemple \(D_8\) pour un dé à 8 faces), et \(R_x\) l’obtention du résultat x (par exemple \(R_7\) pour un 7).

La probabilité d’obtenir trois fois 7 avec trois lancers d’un dé à 8 faces est :

\[P(R_{7,7,7} \vert D_8) = \dfrac{1}{8 \cdot 8 \cdot 8} \approx 0.2 \%\]Il s’agit donc d’un résultat extraordinaire. Remarquez que si on avez choisi un seuil de 0,1%, le résultat serait ordinaire. La conclusion dépend donc bien des critères choisis au départ, d’où l’importance de s’accorder sur les critères avant tout débat ou expérience.

Nous venons d’effectuer un raisonnement d’inférence fréquentiste : nous avons déterminé la probabilité des faits (une série de trois 7) en fonction des hypothèses (trois lancers d’un dé à 8 faces).

Là ou l’inférence bayésienne entre en jeu et devient extrêmement intéressante c’est quand on se pose un autre type de question.

Imaginons que je prends un des dés sans que vous sachiez lequel. Je le lance en cachette et j’annonce le résultat : 7. Quel dé ai-je le plus probablement utilisé ?

Avec l’inférence fréquentiste on pourrait seulement dire que parmi les dés qui ont au moins 7 faces (8, 10, 12 et 20), tous ont une chance d’avoir été choisis, donc 25% de chance pour chaque. Mais cela est faux ! Car le résultat du dé nous donne une information supplémentaire, qu’on peut exploiter avec l’inférence bayésienne.

L’inférence bayésienne est basée sur le Théorème de Bayes :

\[P(A|B) = \dfrac{P(B|A) \cdot P(A)}{P(B)}\]Il se lit : la probabilité de \(A\) sachant \(B\) est égale à la probabilité de \(B\) sachant \(A\) multipliée par la probabilité de \(A\) divisée par la probabilité de \(B\).

On peut le réécrire en remplaçant \(A\) par \(H\) (hypothèse) et \(B\) par \(x\) (fait). On a alors :

\[P(H|x) = \dfrac{P(x|H) \cdot P(H)}{P(x)}\]Où :

- \(P(H \vert x)\) est la plausibilité de l’hypothèse \(H\) au vu des résultats \(x\)

- \(P(x \vert H)\) est la vraisemblance des résultats \(x\) dans le cadre de l’hypothèse \(H\)

- \(P(H)\) est la plausibilité à priori (avant de prendre en compte les faits \(x\)) de l’hypothèse \(H\)

- \(P(x)\) est la probabilité toutes hypothèses confondues des résultats \(x\)

Dans notre cas, ce qui nous intéresse c’est la probabilité d’avoir utilisé un dé sachant le résultat obtenu.

Dans notre exemple, on sait que le résultat est 7. On cherche donc pour chaque dé :

\[P(D_n|R_7) = \dfrac{P(R_7|D_n) \cdot P(D_n)}{P(R_7)}\]Où :

- \(P(D_n \vert R_7)\) est la probabilité d’avoir utilisé un dé à n faces sachant qu’on a fait un 7

- \(P(R_7 \vert D_n)\) est la probabilité de faire un 7 avec un dé à n faces

- \(P(D_n)\) est la probabilité d’avoir un dé à n faces

- \(P(R_7)\) est la probabilité de faire un 7 peu importe le dé

On sait que les dés à 4 et 6 faces ne peuvent donner de 7, il nous reste donc ceux à 8, 10, 12, et 20 faces.

Il reste donc à calculer \(P(D_8 \vert R_7)\), \(P(D_{10} \vert R_7)\), \(P(D_{12} \vert R_7)\) et \(P(D_{20} \vert R_7)\).

Supposons, à priori, que chaque dé a une chance égale d’être choisi. On a donc :

\[P(D_8) = P(D_{10}) = P(D_{12}) = P(D_{20}) = 25\%\]Calculons ensuite la probabilité de faire un 7 quelque soit le dé. Elle vaut la probabilité de faire un 7 avec un dé à 8 faces fois la probabilité d’avoir un dé à 8 faces, plus la probabilité de faire un 7 avec un dé à 10 faces fois la probabilité d’avoir un dé à 10 faces, etc.

\[P(R_7) = \dfrac{1}{8} * 0.25 + \dfrac{1}{10} * 0.25 + \dfrac{1}{12} * 0.25 + \dfrac{1}{20} * 0.25 \approx 8.96\%\]On dispose maintenant de toutes les informations pour calculer les différentes \(P(D_n \vert R_7)\).

\[P(D_8 \vert R_7) = \dfrac{1/8 \cdot 0.25}{0.0896} \approx 34.9\%\] \[P(D_{10} \vert R_7) = \dfrac{1/10 \cdot 0.25}{0.0896} \approx 27.9\%\] \[P(D_{12} \vert R_7) = \dfrac{1/12 \cdot 0.25}{0.0896} \approx 23.3\%\] \[P(D_{20} \vert R_7) = \dfrac{1/20 \cdot 0.25}{0.0896} \approx 13.9\%\]Le dé a 8 faces est donc le plus probablement (34,9%) celui utilisé. Pour s’en assurer il serait cependant fort utile de répliquer l’expérience.

Faisons un autre lancer avec le même dé caché (sans toujours savoir réellement duquel il s’agit).

Imaginons que le résultat est 3.

Nous pouvons alors recalculer nos probabilités. La grande différence est que cette fois-ci nous avons déjà un indice sur les probabilités à priori : alors que nous avions avant choisi 25% pour chaque dé (ce qui est sensé, mais, en l’absence de preuve, reste arbitraire), nous pouvons maintenant utiliser les résultats précédents comme valeurs à priori (les fameux \(P(D_n)\)).

Calculons d’abord \(P(R_3)\) :

\[P(R_3) = \dfrac{1}{8} * 0.349 + \dfrac{1}{10} * 0.279 + \dfrac{1}{12} * 0.233 + \dfrac{1}{20} * 0.139 \approx 9.79\%\]Calculons alors les différents \(P(D_n \vert R_3)\) :

\[P(D_8 \vert R_3) = \dfrac{1/8 \cdot 0.349}{0.0979} \approx 44.6\%\] \[P(D_{10} \vert R_3) = \dfrac{1/10 \cdot 0.279}{0.0979} \approx 28.5\%\] \[P(D_{12} \vert R_3) = \dfrac{1/12 \cdot 0.233}{0.0979} \approx 19.8\%\] \[P(D_{20} \vert R_3) = \dfrac{1/20 \cdot 0.139}{0.0979} \approx 7.1\%\]Notre exemple avec les dés est une métaphore de la méthode scientifique. Le résultat du dé est le résultat d’une expérience, et les différents dés sont les différentes hypothèses pouvant expliquer le résultat.

Si on se limitait à une approche fréquentiste, il se pourrait que plusieurs hypothèses nous semblent équivalentes et on ne pourrait pas trancher. Mais avec une approche bayésienne, plus complexe mais plus puissante, on dispose d’un outil pour discriminer les hypothèses selon leur probabilité au regard des résultats.

Il est intéressant de noter que chacun de nos lancers a conforté l’hypothèse du dé à 10 faces, mais qu’ils ont conforté encore plus celle du dé à 8 faces. Cela montre l’importance de ne pas privilégier une hypothèse isolée juste parce que les faits la confirment, encore faut-il qu’elle soit celle qui le soit le plus.

En effet, imaginons que j’adopte une approche simpliste de la science et que je défende l’hypothèse “c’est le dé à 10 faces qui est utilisé”. Je fais deux lancers (deux expériences) et chacun confirme mon hypothèse. Je clame alors haut et fort “j’avais raison, c’est le dé à 10 faces, c’est prouvé !”.

Une approche méthodique, par l’inférence bayésienne, donne un résultat plus précis en hiérarchisant les hypothèses en fonction de leur plausibilité au regard des faits.

Pour conclure cette partie, voici une petite illustration :

— C'est bon ! Les éclairs ne tuent que 45 Américains par an, les chances de mourir sont de seulement une sur 7000000. Continuons !

Cette image illustre la différence qu’il y a entre \(P(H)\) et \(P(H \vert x)\) :

- \(P(H)\) : la probabilité de mourir de la foudre

- \(P(H \vert x)\) : la probabilité de mourir de la foudre en étant près d’un arbre durant un orage

Les curseurs de croyance

Dans la vie courante, nous n’allons pas calculer des probabilités bayésiennes à chaque fois qu’un problème se pose. Il nous serait donc fort utile de bénéficier des avantages de ce mécanisme en se débarrassant d’une partie de sa complexité.

C’est là qu’entrent en jeu les curseurs de croyance, ou curseurs de plausibilité, qui permettent de se représenter bien plus facilement et intuitivement ces mécanismes.

Il s’agit d’associer à chacune de nos croyances un curseur allant de 0 à 100%, de “je n’y crois absolument pas” à “j’y crois absolument”, de “je n’ai que des doutes, aucune certitude” à “je n’ai que des certitudes, aucun doute”. Ce curseur peut ensuite évoluer dans un sens ou un autre en fonction des nouveaux éléments dont nous avons connaissance, et plus ou moins loin en fonction de la solidité des preuves.

Pour chaque hypothèse, j’ajuste mon curseur en fonction de mon adhésion. Et à chaque fois que j’ai connaissance d’un nouvel élément probant, je déplace mon curseur.

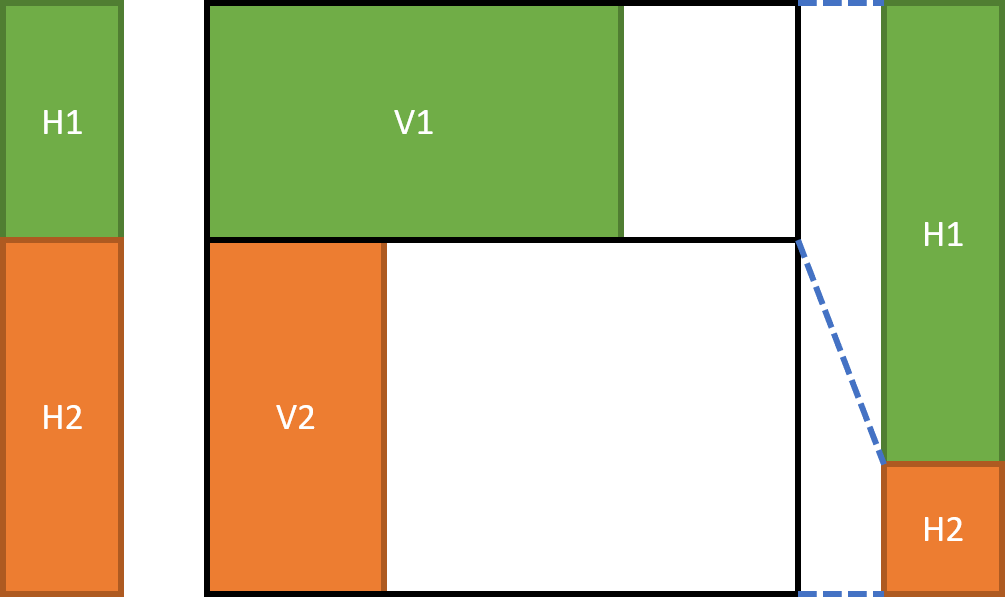

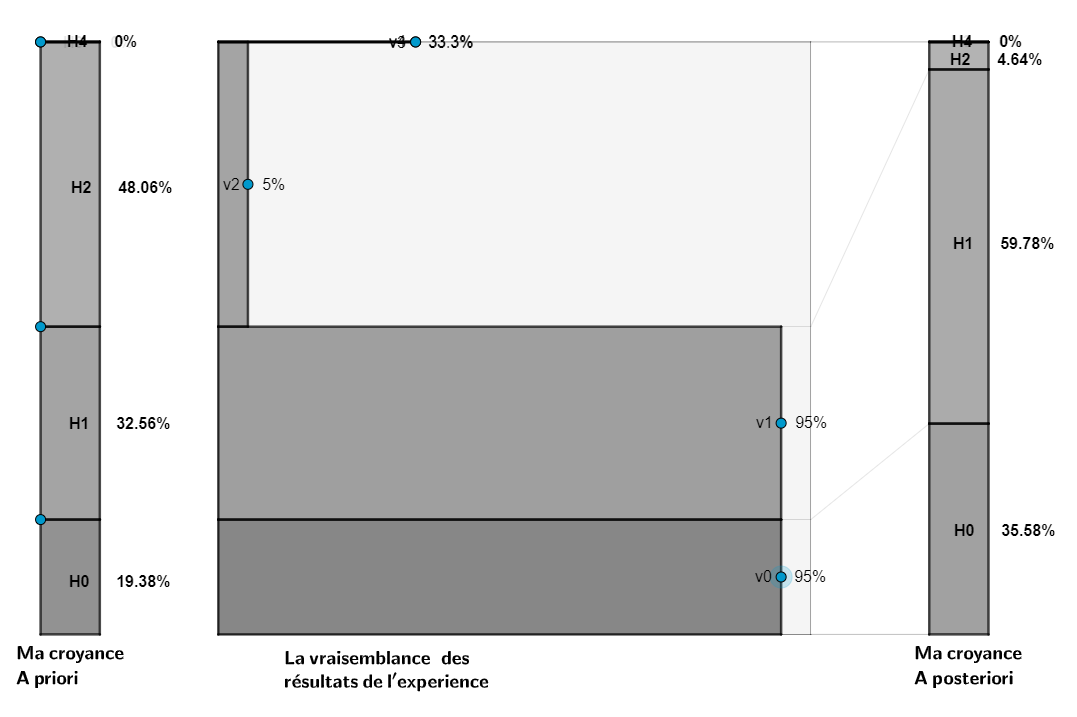

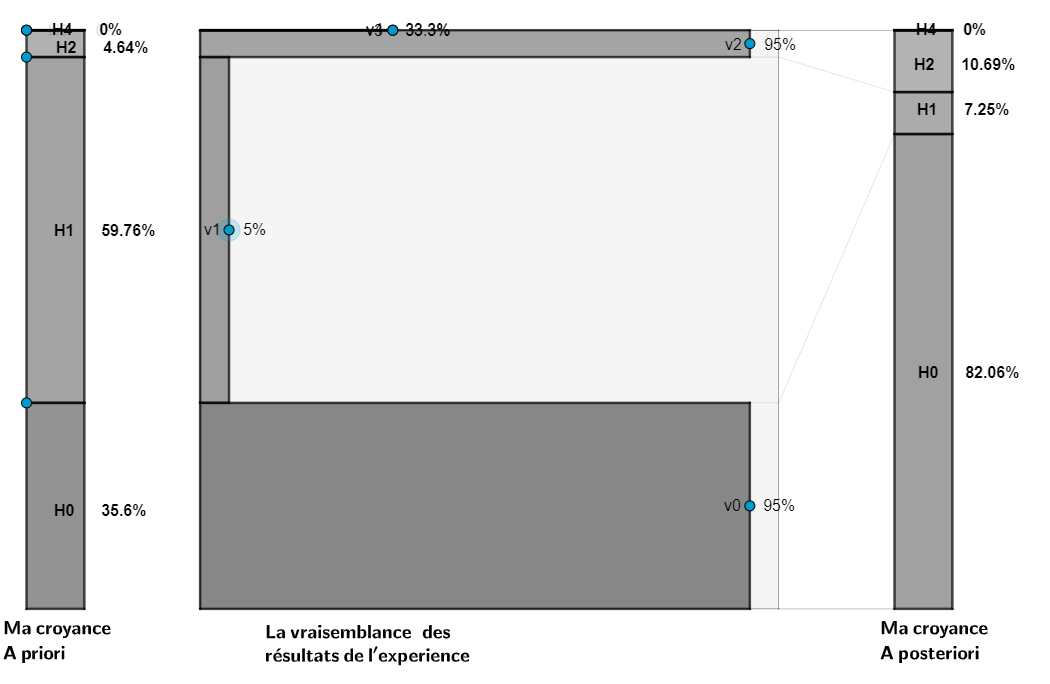

Julia Galef illustre ce processus sous forme de diagramme64 :

Dans la colonne de gauche, on trouve nos hypothèses, tel qu’on y adhère à un instant t. Par exemple je crois à l’hypothèse H1 à 40% et à l’hypothèse H2 à 60%.

Le carré central représente les nouveaux éléments probants qui arrivent à notre connaissance. Les deux zones V1 et V2 représentent la vraisemblance des résultats au vu des hypothèses H1 et H2. Plus la zone est large, plus la vraisemblance est forte.

Dans la colonne de droite, on retrouve nos hypothèses, ajustées en fonction des vraisemblances. On augmente notre adhésion en fonction de la surface des rectangles de la zone centrale.

Pour que ça soit plus clair, prenons un exemple concret, en nous aidant de l’excellent outil visuel créé par Christophe Michel.

Il peut être utilisé en ligne (https://www.geogebra.org/m/Y3epyFff) ou ouvert sur l’application GeoGebra sur ordinateur ou smartphone.

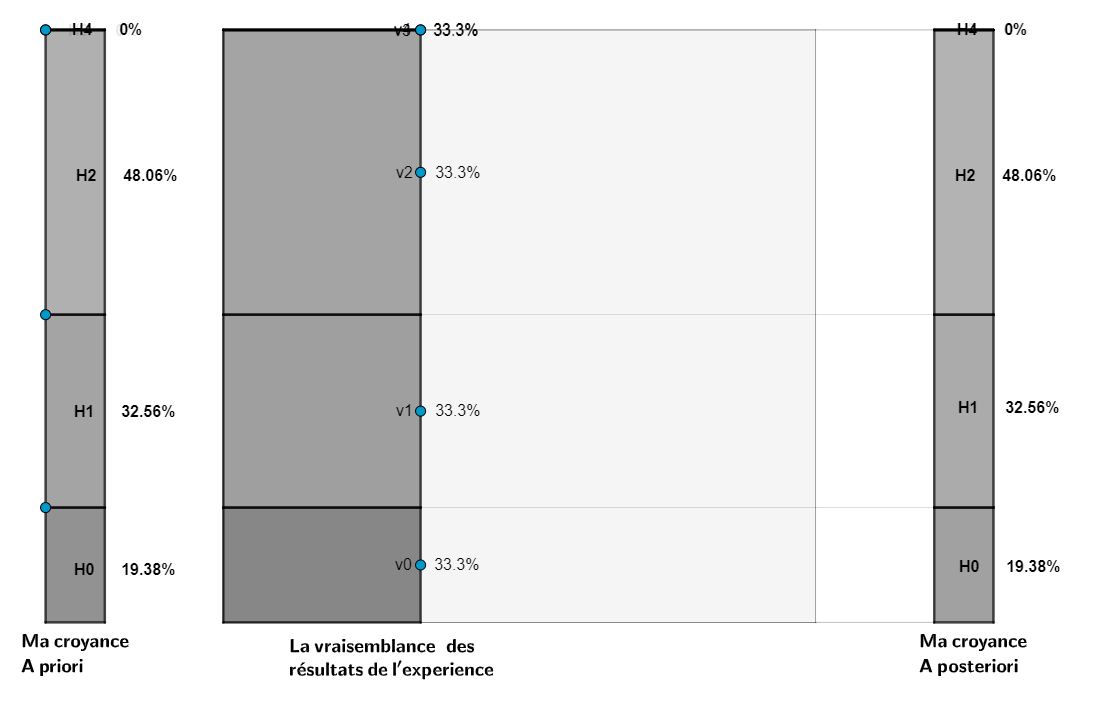

Il permet une interaction avec le diagramme et de jouer avec les probabilités :

Pour notre exemple, imaginons que je me demande qui a construit les pyramides d’Égypte et que j’ai trois hypothèses :

- H0 : les Égyptiens antiques ont construit les pyramides. J’y crois à 19,38%.

- H1 : les extraterrestres ont construit les pyramides. J’y crois à 32,56%.

- H2 : les pyramides ont été construites par les Romains (et donc datent de seulement 2000 ans). J’y crois à 48,06%.

Or j’apprends qu’on a daté les pyramides à plus de 4000 ans et le test me semble fiable. Les résultats de l’expérience sont vraisemblables dans le cas des hypothèses H0 et H1 et ne le sont pas pour H2. J’adapte mes curseurs en conséquence :

Je crois maintenant en H0 à 35,58%, en H1 à 59,78% et en H2 à 4,64%.

Un nouvel élément de preuve apparait : les bâtisseurs utilisaient des outils antiques, et on a pu démontrer leur efficacité pour découper le granite. Ces faits sont vraisemblables pour H0 et H2 et non pour H1 (les extraterrestres ont une technologie avancée). J’adapte mes curseurs en conséquence :

Je crois maintenant en H0 à 82,06%, en H1 à 7,25% et en H2 à 10,69%.

Et, jusqu’à l’apparition de nouveaux éléments probants, ce sera ma croyance.

Note : dans le cas où les probabilités de plusieurs hypothèses sont très proches, il est sage de ne pas choisir une hypothèse, même si elle est la plus probable, et d’attendre d’autres éléments de preuve.

Dans la vie courrante, même sans penser en termes de probabilité, on peut ainsi hiérarchiser les différentes hypothèses selon notre adhésion, qui se met à jour en fonction des preuves dont nous disposons.

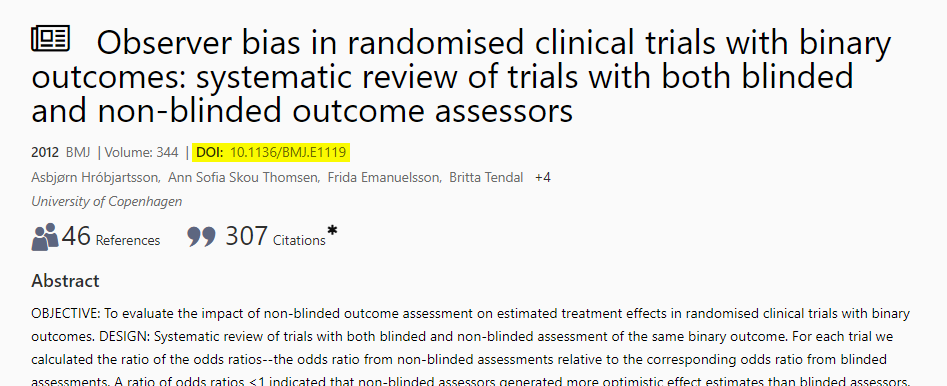

Les niveaux de preuve

Retrouvez un résumé de cette section ici : [En bref] Niveaux de preuve

Une preuve est, d’une manière très générale65 :

Ce qui sert à établir qu’un fait est vrai.

Plus spécifiquement, une preuve scientifique est une preuve qui sert à supporter ou réfuter une hypothèse ou théorie scientifique, c’est à dire qui respecte le critère de scientificité (toute affirmation objectivable découlant d’une démarche intellectuelle structurée).

Or il n’est pas difficile de concevoir que toutes les preuves ne se valent pas.

Dans le cadre d’une démarche rationnelle, on peut hiérarchiser les preuves selon des niveaux de fiabilité.66 67 68 69 70 71 72

- Niveau de preuve très élevé (Grade A – Preuve établie)

- Consensus scientifique

- Méta-analyses

- Niveau de preuve élevé (Grade B – Présomption)

- Essais comparatifs randomisés

- Études de cohortes

- Niveau de preuve modéré (Grade C+ – Preuve modérée)

- Études prospectives contrôlées

- Études cas-témoin

- Niveau de preuve faible (Grade C- – Preuve faible)

- Étude de cas

- Études rétrospectives

- Études prospectives non contrôlées

- Études épidémiologiques descriptives

On peut aussi hiérarchiser les indices, qui n’ont aucune valeur probante :

- Indices forts

- Parole d’expert

- Indices moyens

- Expérience personnelle

- Témoignage individuel direct

- Indices faibles

- Témoignage individuel indirect

- Sagesse populaire

Note : des études dont la méthodologie est mauvaise (manque de contrôle, biais statistiques ou d’échantillonnage, etc.) et qui sont de fait rejetées par la communauté scientifique peuvent parfois avoir une valeur d’indice.

Ainsi, lorsque nous mettons à jour nos curseurs de croyance, il nous faut prendre en compte le niveau de fiabilité des preuves apportées.

Imaginons par exemple que je me documente sur l’efficacité de la sève d’artémisia sur les brulures du premier degré. A un instant t je dispose de deux preuves : un essai comparatif randomisé indiquant son efficacité et une étude cas-témoin indiquant son inefficacité. Dans ce cas, placer mon curseur à 50% (“j’y crois à moitié”) serait fautif, car ce serait considérer que les deux études ont la même valeur probante. Je vais plutôt le placer à 80% en faveur de l’efficacité. En effet l’essai comparatif randomisé est une preuve de grade B, donc plus probante que l’étude cas-témoin de grade C+.

Les niveaux de preuve ne sont pas les seuls critères à prendre en compte : on doit exclure les études qui ont des biais méthodologiques, d’échantillonnage, d’évaluation, etc., et aussi considérer la taille des échantillons, les traitements statistiques des données, etc.

Je ne rentre pas dans les détails et ferai peut-être un article dédié pour expliquer tout cela. Mais en résumé, il faut retenir que toutes les preuves n’ont pas la même valeur.

Quelques outils méthodologiques

Dans cette section je décris brièvement quelques outils méthodologiques de base pour mener à bien une réflexion critique.

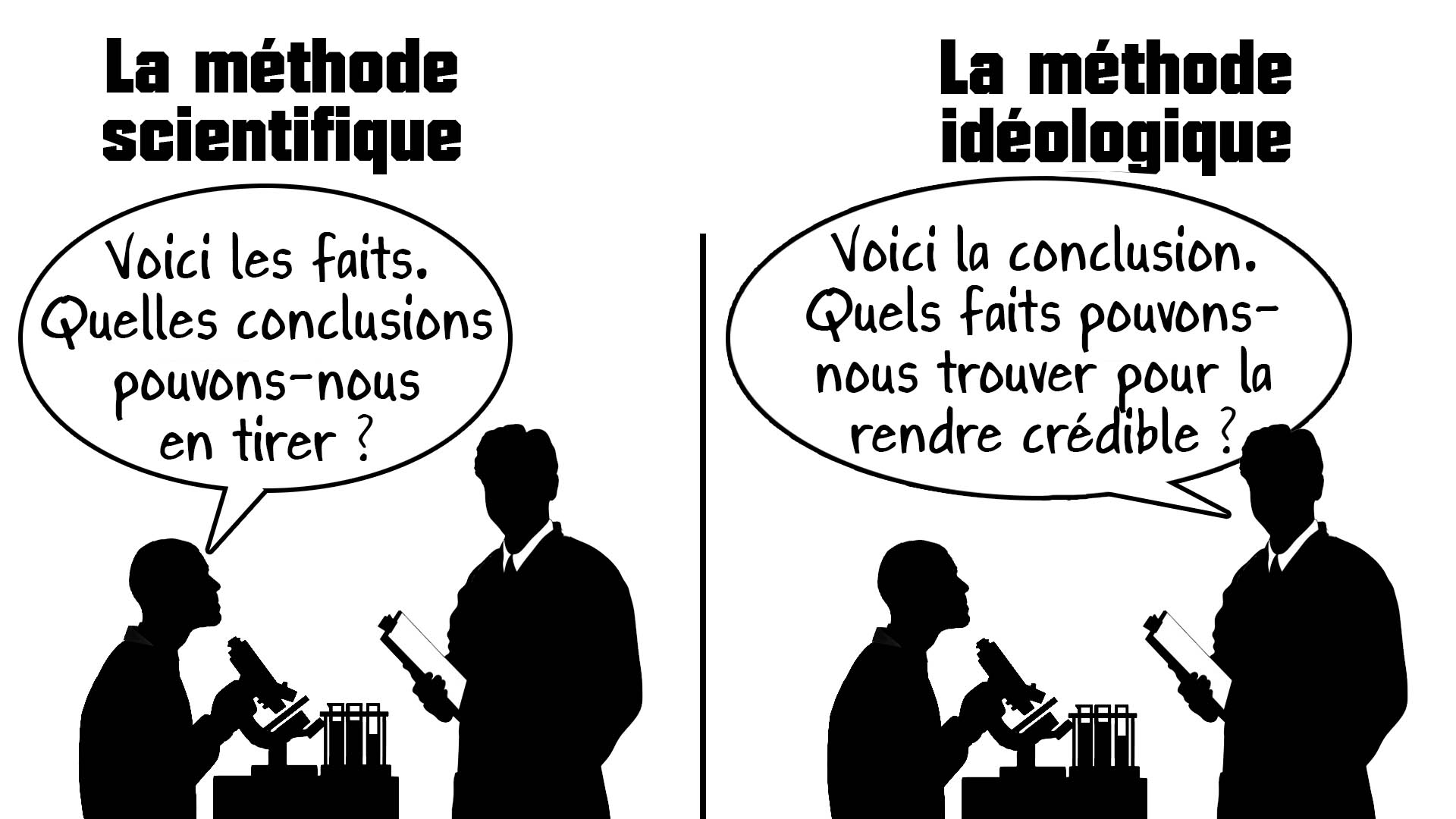

Partir des faits

Toute explication non étayée par des faits qui la démontrent n’est pas une preuve, aussi cohérente soit-elle. Ce qui nous intéresse ce n’est pas à quel point une hypothèse explique les faits, mais à quel point les faits confirment l’hypothèse et si celle-ci est la plus plausible parmi toutes les hypothèses au vu des faits.

Il est donc important d’aller des faits vers les hypothèses et non l’inverse. Cela ne signifie pas pour autant que nous ne pouvons postuler aucune hypothèse sans avoir d’abord examiné les faits. Bien souvent d’ailleurs on nous présente plusieurs hypothèses avant que nous ayons eu l’occasion de nous renseigner sur les faits.

Il s’agit simplement de ne pas favoriser une hypothèse à priori, et de ne pas chercher les faits qui valident une hypothèse, mais bien d’évaluer les hypothèses au regard des faits.

Assurons-nous bien du fait, avant de nous inquiéter de la cause

Bernard Le Bouyer de Fontenelle, écrivain et scientifique français, écrivait en 168773 :

Il serait difficile de rendre raison des histoires et des oracles que nous avons rapportés, sans avoir recours aux démons, mais aussi tout cela est-il bien vrai ? Assurons-nous bien du fait, avant de nous inquiéter de la cause. Il est vrai que cette méthode est bien lente pour la plupart des gens, qui courent naturellement à la cause, et passent par-dessus la vérité du fait ; mais enfin nous éviterons le ridicule d’avoir trouvé la cause de ce qui n’est point.

Rien n’est plus normal que d’en faire autant sur toutes sortes de matières. Je ne suis pas si convaincu de notre ignorance par les choses qui sont, et dont la raison nous est inconnue, que par celles qui ne sont point, et dont nous trouvons la raison. Cela veut dire que non seulement nous n’avons pas les principes qui mènent au vrai, mais que nous en avons d’autres qui s’accommodent très bien avec le faux.

Cette maxime, assurons-nous bien du fait, avant de nous inquiéter de la cause, est l’un des piliers de la pensée critique.

Pour en savoir plus :

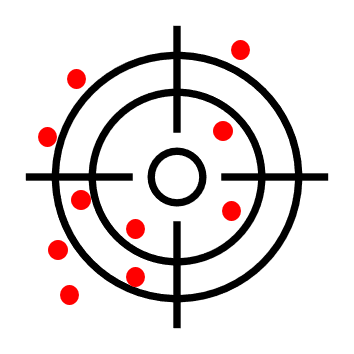

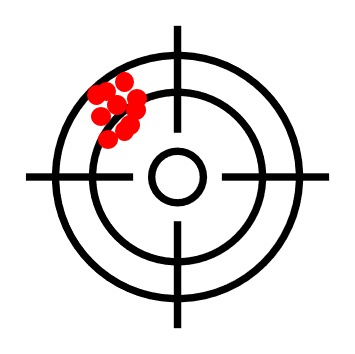

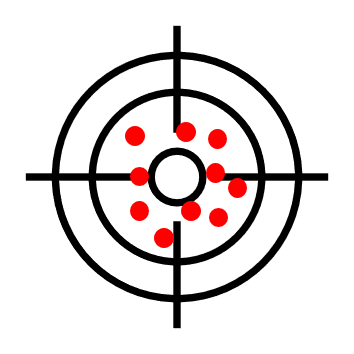

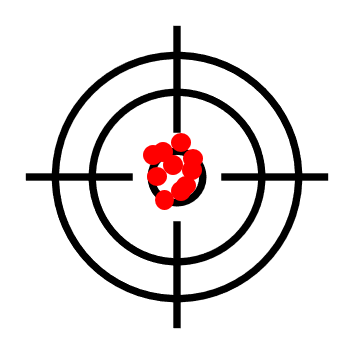

Distinguer précision et exactitude

Dans son livre L’art du doute ou Comment s’affranchir du prêt-à-penser74, Henri Broch, le “père de la zététique moderne” fait la distinction entre ce qui est précis et ce qui est exact :

- Précis c’est quand les résultats sont groupés, quand les éléments pointent dans la même direction

- Exact c’est quand la moyenne des résultats est proche de la réalité

On peut illustrer les 4 cas possibles avec l’image de la cible, dont le centre est la vérité, et des impacts, qui représentent nos valeurs, indices, etc.

Logique de base

Retrouvez un résumé de cette section ici : [En bref] Logique de base

Implication, contraposée, réciproque, équivalence

En logique ces quatre termes sont centraux.

L’implication exprime une relation de causalité selon laquelle une proposition en entraine une autre si elle est vraie. Elle se note \(A \Rightarrow B\) et se lit A implique B.

Par exemple : si je suis humain alors je suis mortel.

La contraposée d’une implication est sa réécriture sous une forme négative. Elle a exactement la même valeur logique. La contraposée de \(A \Rightarrow B\) (A implique B) est \(\neg B \Rightarrow \neg A\) (non B implique non A).

Par exemple : si je ne suis par mortel alors je ne suis pas humain.

La réciproque d’une implication est son inverse. Elle n’a pas la même valeur logique. La réciproque de \(A \Rightarrow B\) (A implique B) est \(B \Rightarrow A\) (B implique A).

Par exemple : si je suis mortel alors je suis humain.

On parle d’équivalence quand une implication et sa réciproque sont toutes les deux vraies. Elle se note \(A \Leftrightarrow B\) et se lit A équivaut à B. On dit aussi que A est nécessaire et suffisant à B.

Par exemple : si je suis humain alors je suis mortel, et si je suis mortel alors je suis humain.

Modus Ponens et Modus Tollens

Derrière ces termes latins se cachent deux principes très simples et fondamentaux de la logique.

Le modus ponens est la déduction du conséquent. C’est à dire que si A implique B et que A est vrai, alors B est vrai. On écrit formellement cette relation :

\[A, A \Rightarrow B \vdash B\]Cela se lit de A et A implique B on déduit B.

Par exemple :

- On sait que tous les poissons respirent sous l’eau. (\(A \Rightarrow B\))

- Or le saumon est un poisson. (\(A\))

- Donc le saumon respire sous l’eau. (\(B\))

Le modus tollens est la validité de la contraposée. La contraposée de A implique B est non A implique non B. On écrit formellement cette relation :

\[A \Rightarrow B \vdash \neg B \Rightarrow \neg A\]Cela se lit de A implique B on déduit non B implique non A.

Par exemple :

- On sait que tous les poissons respirent sous l’eau. (\(A \Rightarrow B\))

- Or l’ours ne respire pas sous l’eau. (\(\neg B\))

- Donc l’ours n’est pas un poisson. (\(\neg A\))

Affirmation du conséquent et négation de l’antécédent

Les deux principes précédents sont logiquement valides, mais il existe deux raisonnements fallacieux très similaires dans leur forme qui sont logiquement invalides : l’affirmation du conséquent et la négation de l’antécédent.

L’affirmation du conséquent c’est considérer une condition suffisante comme nécessaire. Elle dit que si A implique B et que B est vrai, alors A est vrai. On écrit formellement cette affirmation fausse :

\[B, A \Rightarrow B \vdash A\]Cela se lit de B et A implique B on déduit A.

Par exemple :

- On sait que tous les poissons respirent sous l’eau. (\(A \Rightarrow B\))

- Or le crabe respire sous l’eau. (\(B\))

- Donc le crabe est un poisson. (\(A\))

La négation de l’antécédent c’est considérer que la réciproque d’une implication est toujours vraie. Elle dit que si A implique B alors non A implique non B. On écrit formellement cette affirmation fausse :

\[A \Rightarrow B \vdash \neg A \Rightarrow \neg B\]Cela se lit de A implique B on déduit non A implique non B.

Par exemple :

- On sait que tous les poissons respirent sous l’eau. (\(A \Rightarrow B\))

- Or le crabe n’est pas un poisson. (\(\neg A\))

- Donc le crabe ne respire pas sous l’eau. (\(\neg B\))

Bien définir l’hypothèse testée

Lorsqu’on veut s’assurer de la véracité d’une hypothèse, il est très important de bien la définir avant d’investiguer. On ne teste qu’un seul paramètre à la fois, tous les autres paramètres étant égaux par ailleurs.

Prenons un exemple.

Lors d’un voyage en Armorique je croise le druide Panoramix, qui m’explique que la potion magique ne fonctionne que si on ajoute du gui cueilli à minuit, en toge blanche, pieds nus, dans un chêne avec une serpe d’or.

Ah ? Je décide de tester. Je cueille du gui à 20h, en jeans, avec des chaussures, dans un tilleul avec un serpe en argent. Et, effectivement, la potion ne marche pas. Je teste ensuite en faisant comme Panoramix a dit et là, ça marche.

Ai-je bien testé son affirmation ? Non. En effet, j’ai fait varier tous les paramètres en même temps. Dans ce cas, comment savoir s’ils ont tous un effet ?

J’aurais par exemple pu tester l’influence de l’heure de cueillette en ajoutant du gui cueilli en toge blanche, pieds nus, dans un chêne avec une serpe d’or, mais à 20h au lieu de minuit. Si dans ce cas cela ne marche pas (en supposant qu’on a répliqué l’expérience de nombreuses fois, etc.) alors c’est bien que l’horaire a une influence. Si ça marche quand même, c’est qu’il n’a pas d’influence.

Avoir des paramètres clairs, objectivables, quantifiables

Afin de pouvoir éprouver des hypothèses, il faut définir des paramètres qui ne soient pas ambigus.

Par exemple, si on cherche à éprouver l’affirmation selon laquelle diffuser de la musique classique favorise la croissance des plantes, il faut par exemple préciser :

- Parle-t-on de toute musique classique ou seulement une sous-catégorie ?

- Quel type de diffusion ? (durée, fréquence, volume, etc.)

- Est-ce que ça marche sur toutes les plantes ?

- Combien de temps doit-on attendre avant d’avoir un effet ?

- Qu’est-ce qu’on mesure ? (taille des plantes, nombre de graines, la masse sèche, etc.)

- Quels seuils significatifs ? Si on a choisi de mesurer l’effet sur la taille, quelle augmentation faut-il atteindre et en combien de temps pour que ça soit significatif ?

- Etc.

Comparer à un échantillon standard

Lors de toute thérapie, des effets contextuels influent sur les symptômes et la rémission des patients.75 Le plus connu de ces effets est l’effet placébo, qui est un procédé thérapeutique n’ayant pas d’efficacité propre mais agissant sur le patient par des mécanismes psychologiques et physiologiques.

Si on teste une thérapie, par exemple un nouveau médicament, il nous faut déterminer s’il a une efficacité propre, c’est-à-dire s’il est plus efficace que la guérison spontanée du corps combinée aux effets contextuels.

Par exemple si je veux tester l’efficacité du jus de citron sur les maux de tête, il n’est pas suffisant de l’administrer à des personnes souffrant de maux de tête et de regarder si une heure après elles vont mieux. En effet, peut-être ont-elles guéri par effet placébo, ou même simplement parce que le mal de tête s’est naturellement résorbé.

Le protocole standard vise à comparer deux groupes, un (le groupe test) auquel on administre le médicament évalué et l’autre (le groupe contrôle) auquel on donne un placébo en tout point identique (même couleur, forme, odeur, gout, etc.), mais auquel on a retiré le principe actif que l’on veut tester. On compare ensuite les effets dans les deux groupes.

Ce protocole est d’une extrême importance, car les effets contextuels ont une grosse influence sur l’état des patients, notamment sur les douleurs, nausées et fatigues.75

Les effets contextuels et les protocoles de tests cliniques feront peut-être l’objet d’un article ultérieur, bien plus détaillé, car le sujet est vaste.

Ce qu’il faut bien retenir, c’est qu’il faut toujours s’assurer de comparer nos résultats avec un groupe contrôle, même lorsqu’il ne s’agit pas de tests médicaux.

Par exemple si on cherche à mettre à l’épreuve les prétentions d’un sourcier, il faut comparer ses capacités à trouver de l’eau à celles de personnes aussi familières que lui avec la région qu’il arpente, mais qui n’ont pas de “don” de sourcier. En effet, s’il trouve de l’eau plus souvent que le commun des mortels, peut-être est-ce parce qu’il connait bien la forêt et sait quelles plantes poussent près des points d’eau ?

Dans cet exemple, idéalement on devrait monter un protocole indépendant de l’environnement. Par exemple on pourrait prendre un terrain complètement uniforme sous lequel on fait passer un large tuyau dans lequel on peut envoyer de l’eau à volonté. On demande au sourcier de se placer dessus et de déterminer si oui ou non de l’eau coule sous ses pieds.

D’ailleurs, de nombreux protocoles de ce genre ont été mis en place pour tester des centaines de sourciers. Aucun sourcier n’a pû faire montre d’une efficacité supérieure au hasard.76 77 78 79

Richard Monvoisin illustre la nécessité d’un groupe contrôle par l’histoire du panneau anti-girafe80 :

Deux types sont dans le désert. Il y en a un qui est en train de planter un panneau.

L’autre lui demande :

— Mais tu fais quoi ?

— Je plante un panneau anti-girafe !

— Mais il n’y a pas de girafes dans le désert !

— Ah ! C’est bien la preuve que ça marche !

Partir de l’hypothèse nulle

Ce point méthodologique découle du principe de parcimonie des hypothèses vu plus tôt. Il dit qu’en l’absence de preuve du contraire, il n’y a aucune raison de privilégier un échantillon ou un groupe plutôt qu’un autre.

On appelle hypothèse nulle cette hypothèse de départ qui postule l’égalité des paramètres statistiques. Par exemple l’hypothèse nulle dans un test clinique postule qu’il n’y a pas de différence d’effet entre un groupe qui prend un médicament et un autre qui prend un placébo. Le but de l’essai clinique est alors de vérifier si cette hypothèse se confirme ou si le médicament a bien un effet propre.

Faire un échantillonnage sans biais

Lorsqu’on choisit un échantillon (notamment de population) pour effectuer des tests, il doit être justifié et représentatif de ce qu’on veut tester. Par exemple si on veut évaluer le taux de confiance des Français en la médecine, on aura des résultats très différents selon qu’on fait notre sondage à la sortie du bar du coin ou de la faculté de médecine.

Les méthodes d’échantillonnages peuvent être très complexes et varier grandement en fonction du type de problème. Voici cependant deux conseils, très basiques, pour avoir une première approche pas trop mauvaise.

Tout d’abord l’échantillon doit éviter les biais de sélection, c’est-à-dire qu’il ne doit pas contenir de sous-groupe déséquilibré pouvant infléchir les résultats. Par exemple si je teste l’efficacité d’un médicament pour les maux de tête, je ne dois pas avoir plus de gens qui ont des migraines chroniques dans le groupe contrôle que dans le groupe test.

Ensuite l’échantillon doit être suffisamment grand pour que le test soit à la fois puissant (être en mesure de rejeter l’hypothèse nulle avec une grande probabilité si celle-ci est fausse) et significatif (être en mesure de conserver l’hypothèse nulle avec une grande probabilité si celle-ci est vraie).

Note : les paragraphes suivants contiennent quelques formules de maths. Vous n’avez pas besoin de les comprendre. Retenez seulement qu’on peut facilement évaluer la fiabilité de la taille d’un échantillon.

D’une manière générale, on peut avoir une idée grossière de la taille minimale que devrait avoir un échantillon pour éviter les biais statistiques (en supposant qu’il soit par ailleurs représentatif) avec la formule suivante :

\[N = \frac{t^2 \cdot p \cdot (1-p)}{m^2}\]Avec :

- \(N\) la taille minimale de l’échantillon

- \(t\) le niveau de confiance selon la loi normale centrée réduite (par ex. 1.96 pour 95% de confiance)

- \(p\) la proportion estimée de la population qui présente la caractéristique (lorsqu’inconnue, on utilise \(p = 0.5\), c’est-à-dire la dispersion statistique la plus grande)

- \(m\) la marge d’erreur tolérée

Note 1 : le niveau de confiance indique le pourcentage de résultats qui sont probablement vrais (plus ou moins la marge d’erreur). Par exemple si on a un niveau de confiance de 90% et une marge d’erreur de 5%, alors on peut dire que 90% de nos résultats sont vrais à 5% près.

Note 2 : on peut calculer facilement la valeur de \(t\) dans Excel en utilisant la formule LOI.NORMALE.STANDARD.INVERSE.N.

Par exemple, imaginons que nous volons tester si les êtres humains sont sensibles aux ondes 5G, avec 95% de confiance et 1% de marge d’erreur. On a :

\[N = \frac{1.96^2 \cdot 0.5 \cdot (1-0.5)}{0.01^2} = 9604\]Notre étude devrait donc porter sur au moins 9604 personnes pour éviter les biais statistiques.

On peut se servir de la même formule pour évaluer, grossièrement, la confiance que l’on peut accorder à un test statistique en fonction de la taille de l’échantillon. En effet, on peut l’écrire ainsi :

\[t = \sqrt{ \frac{N \cdot m^2}{p \cdot (1-p)} }\]Par exemple sin on avait conduit notre étude précédente sur un échantillon de 1000 personnes, on aurait :

\[t = \sqrt{ \frac{1000 \cdot 0.01^2}{0.5 \cdot (1-0.5)} } \approx 0.63\]Ce qui correspond (via la formule LOI.NORMALE.STANDARD.N sous Excel) à une confiance à 74%, c’est-à-dire que 74% des résultats sont dans la marge d’erreur acceptable.

Ces symboles mathématiques peuvent paraitre compliqués, mais ler utilisation est en réalité très simple. Leur utilisation n’est pas très courant, mais lorsqu’une étude nous semble étonnante il peut être utile de vérifier la fiabilité de son échantillon.

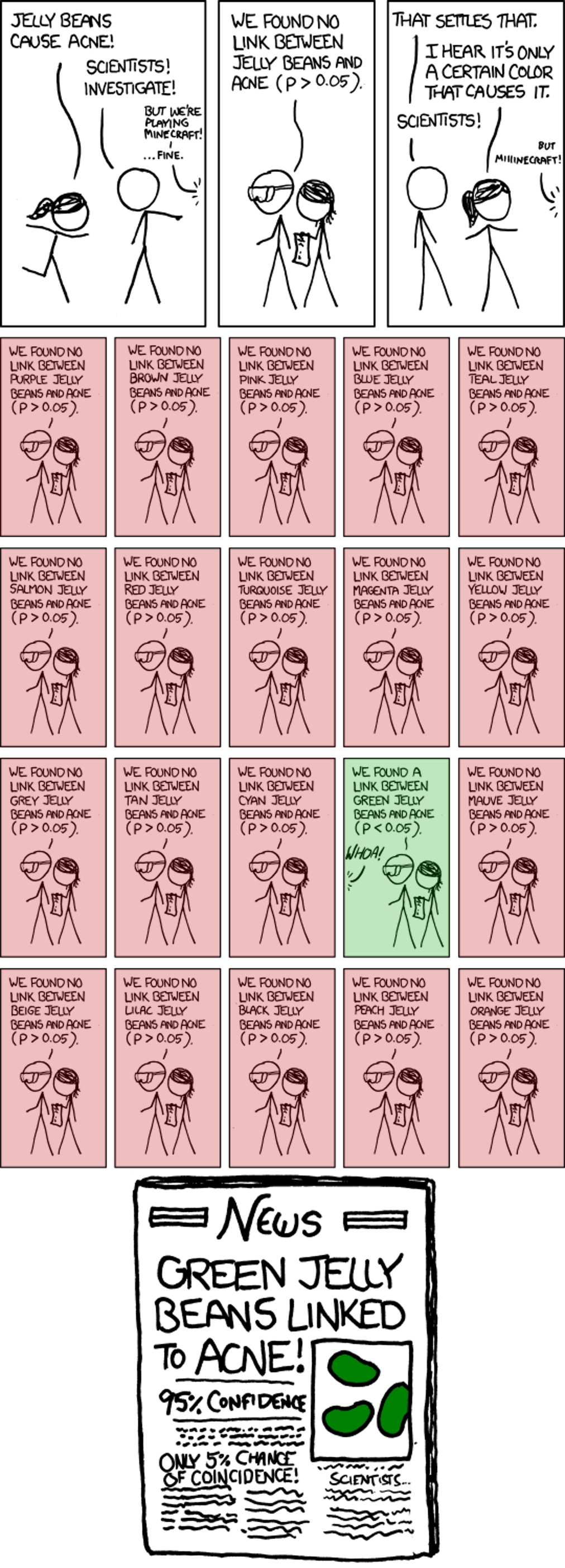

Répliquer les études

Comme vu précédemment, dans tout calcul statistique il y a une marge d’erreur (pour ne pas avoir d’erreur il faudrait un échantillon infini). Si par exemple on accepte une marge d’erreur de 5%, on aura en moyenne 5% de faux positifs (ou de faux négatifs), donc de résultats faux.

C’est pour cela qu’une seule étude n’est jamais une preuve suffisante pour amener à un consensus scientifique.

C’est aussi pour cette raison que sur de nombreux sujets on peut trouver une petite portion d’études qui montrent l’inverse du consensus. C’est uniquement si cette proportion est significativement plus grande que la marge d’erreur qu’il y a probablement un problème plus important.

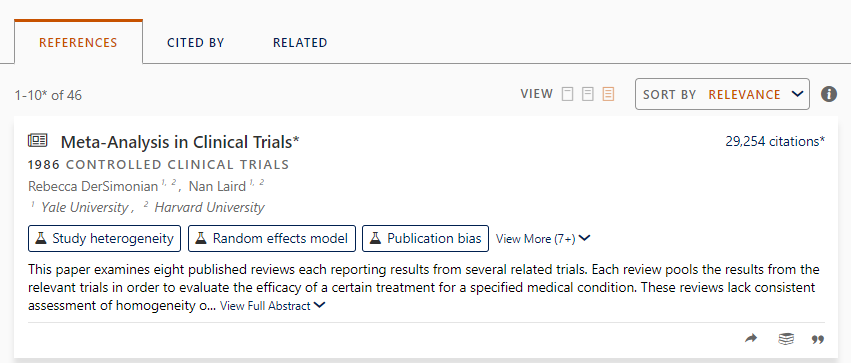

Procéder en double ou triple aveugle

Imaginez que vous voulez tester l’efficacité d’un nouveau médicament pour les maux de tête. Vous avez déterminé des critères objectivables, sélectionné un large échantillon représentatif de la population et séparé les sujets au hasard en deux groupes, l’un contrôle qui reçoit un placébo et l’autre test qui reçoit le médicament.

Vous allez voir les sujets du groupe contrôle : “Bonjour Monsieur Bidule ! Voici votre placébo ! Alors, vous avez toujours mal ?”.

Non, évidemment, vous avez fait les choses bien et les patients ne savent pas s’ils ont reçu le placébo ou le médicament. On appelle cela une étude en simple aveugle.

Pourquoi simple ? Parce que vous-mêmes savez si vous administrez le médicament ou le placébo. Or, si vous avez envie de prouver l’efficacité de votre médicament, il y a de fortes chances que vous serez partial dans vos évaluations, même inconsciemment. On appelle ça le biais de l’observateur.81 82

Pour éviter ça, on a créé le protocole en double aveugle : ni le patient ni l’examinateur ne sait si le patient a reçu le médicament ou le placébo.

On a donc besoin d’une tierce personne. Celle-ci va conditionner les médicaments et les placébos dans un ordre aléatoire, les identifier par un numéro et garder cette identification secrète jusqu’à la fin de l’étude.

Ensuite l’observateur note les résultats de l’expérience. Par exemple :

- Patient avec le “médicament” n°1 : plus de douleur après 15 minutes

- Patient avec le “médicament” n°2 : plus de douleur après 27 minutes

- Patient avec le “médicament” n°3 : plus de douleur après 6 minutes, apparition de nausées

- Patient avec le “médicament” n°4 : plus de douleur après 20 minutes

- Etc.

Enfin, il fait le lien avec les informations de celui qui a conditionné les produits. Par exemple :

- N°1 = médicament

- N°2 = placébo

- N°3 = placébo

- N°4 = médicament

- Etc.

C’est à ce stade qu’on peut ajouter un niveau d’aveugle supplémentaire et faire un protocole en triple aveugle : on donne les résultats ainsi obtenus à un statisticien, mais sans lui dire quelles données correspondent au placébo ou au médicament.

Le double aveugle est le standard minimum a atteindre pour qu’une étude soit robuste. La partie triple aveugle est moins significative puisque les données collectées sont figées et ne peuvent plus être influencée. Pour cette raison la plupart des études se satisfont du double aveugle.

Chercher à réfuter

La démarche scientifique commence toujours par tenter de réfuter les nouvelles hypothèses, par chercher l’erreur. En effet, si l’hypothèse est réfutée alors il ne sert à rien de chercher à l’étayer.

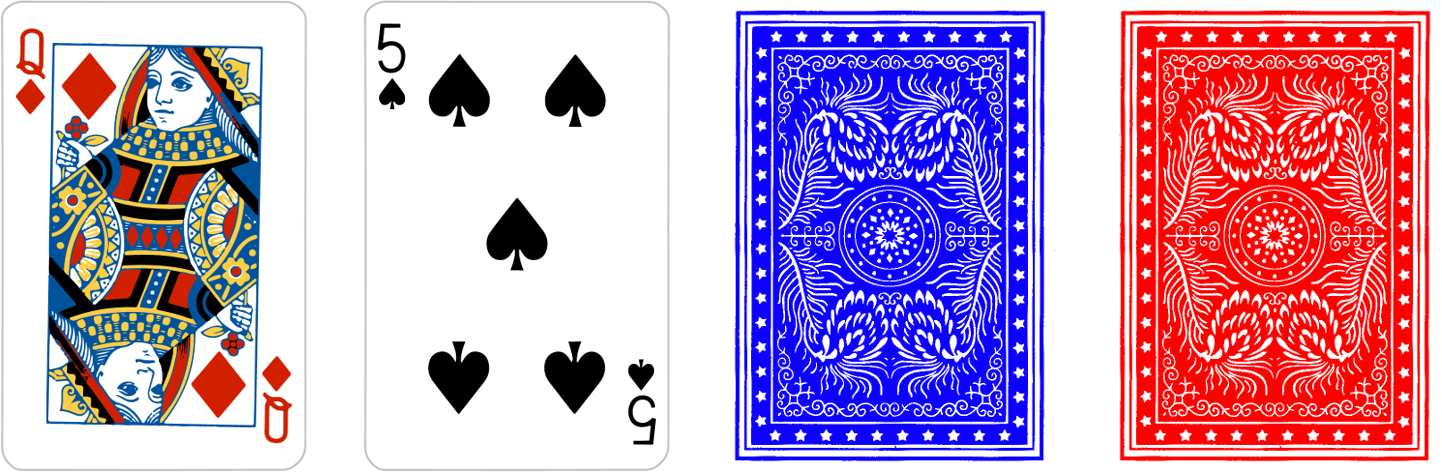

Par exemple : voici 4 cartes à jouer classiques, sans trucage (double face, etc.). Je vous dit que, parmi ces cartes, si une carte a une dame d’un côté alors le dos de la carte est bleu. Quelles cartes devez-vous retourner pour vérifier cette hypothèse ?

Il faut retourner :

- La première carte pour vérifier que le dos n’est pas rouge

- La dernière carte pour vérifier qu’il n’y a pas une dame

On cherche à réfuter l’hypothèse.

En effet, si on retournait le deuxième carte, que la couleur du dos soit bleue ou rouge ne nous apprend rien sur l’hypothèse testée.

De même pour la troisième carte. En effet, qu’on y trouve une dame ou non ne nous dit rien sur la validité de l’hypothèse.

Quelques biais de raisonnement

Retrouvez un résumé de cette section ici : [En bref] Biais de raisonnement

Un biais de raisonnement, ou biais cognitif est une distorsion dans le traitement cognitif d’une information qui peut conduire à des évaluations faussées, des déductions illogiques et des représentations non rationnelles de la réalité.83 84 85

Avoir connaissance de ces biais et s’en prémunir est très important pour éviter de se faire manipuler et avoir une réflexion aussi proche de la vérité que possible.

Je liste ici quelques-uns des biais les plus courants.

Ancrage

Difficulté à se départir d’une première impression.

Dans une expérience86 on demandait aux participants d’estimer des quantités en pourcentage (per ex. la part de pays africains à l’ONU) :

- Étape 1 : on fait tourner une roue crantée allant de 10% à 90% devant les participants pour générer un pourcentage au hasard

- Étape 2 : on présente la quantité à estimer (par exemple la part de pays africains à l’ONU)

- Étape 3 : on demande si les participants pensent que la réponse est plus grande ou plus petite que le pourcentage généré au hasard

- Étape 4 : on leur demande leur propre estimation

Les résultats montrent que le pourcentage aléatoire influençait systématiquement la réponse. Par exemple pour estimer la part de pays africains à l’ONU, un groupe où le pourcentage généré était 10% a répondu en moyenne 25% et un autre où le pourcentage généré était 65% a répondu en moyenne 45%.

Biais culturel

Appréciation de tout phénomène en fonction de ses propres normes culturelles.87

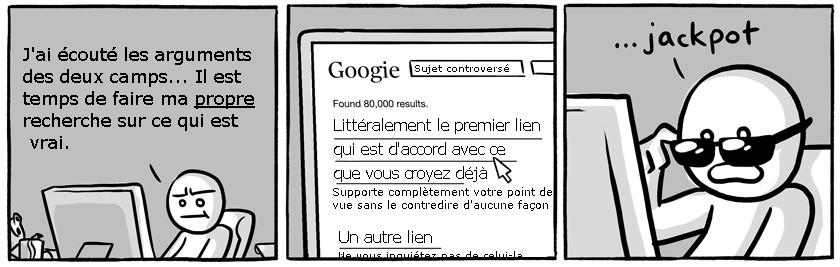

Biais de confirmation

Tendance à noter et à chercher ce qui confirme ses croyances, et à ignorer, ne pas rechercher, ou sous-estimer l’importance de ce qui les contredit.88

Biais des couts irrécupérables

Persister dans une pratique ou croyance à cause de l’investissement déjà réalisé.89

C’est l’application de l’aversion à la perte (attacher plus d’importance à une perte qu’à un gain du même montant) aux couts passés. Cela s’exprime par exemple lorsque quelqu’un qui a payé sa place de cinéma et se rend compte que le film est mauvais décide de rester voir le film pour “éviter de gaspiller” l’argent qu’il a de toute façon dépensé.

Biais du survivant

Se concentrer sur les personnes ou les choses qui ont passé un certain processus de sélection et ignorer ceux qui ne l’ont pas fait, généralement en raison de leur manque de visibilité.90

C’est par exemple le cas lorsqu’on considère que ceux qui donnent des conférences pour expliquer les clés de leur succès sont pertinents en oubliant qu’on ne donne la parole qu’à ceux qui ont réussi. Ou quand on croit que “les produits étaient de meilleure qualité à l’époque” en oubliant que seuls ceux qui sont de qualité ont pu nous parvenir.

Pour en savoir plus :

Biais d’attention

Altération de la perception par des facteurs sélectifs dans l’attention.

Ce biais est notamment responsable de notre tendance à ignorer les pistes de réflexion qui nous déplaisent.85 91 Il peut aussi renforcer l’effet des syndromes anxieux et dépressifs.92

Biais d’optimisme

Tendance à s’attendre plus à des évènements positifs que négatifs.93 94

Biais d’équiprobabilité

Tendance à croire que chaque processus dans lequel l’aléatoire est impliqué correspond à une distribution juste, avec des probabilités égales pour tout résultat possible.95 96 97

Par exemple, une expérience menée en 198898 demandait à des lycéens et des étudiants d’estimer, dans la cas d’un lancer de deux dés équilibrés à 6 faces, si les résultats 11 et 12 avaient la même chance de tomber. Près de 60% répondaient que les deux résultats étaient équiprobables (alors que 11 est deux fois plus probable).

Biais rétrospectif

Tendance à percevoir les évènements qui se sont déjà produits comme étant plus prévisibles qu’ils ne l’étaient réellement avant qu’ils n’aient lieu.99 100

On appelle parfois ce biais l’effet je-le-savais-depuis-le-début.101

Effet Barnum

Accepter une vague description de la personnalité comme s’appliquant spécifiquement à elle-même. 102

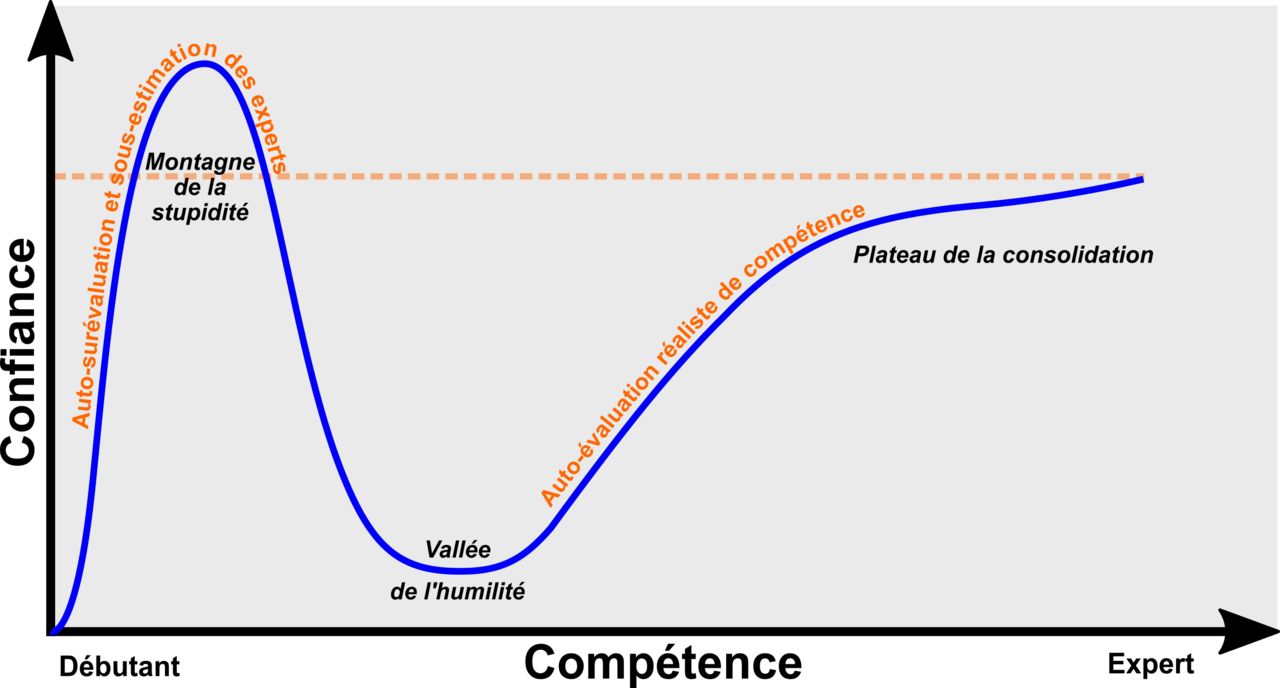

Effet Dunning-Kruger

Sur-estimer ses capacités lorsqu’on est sous-qualifié pour un domaine précis.103

Cet effet correspond à ce qu’on nomme parfois “montagne de la stupidité” :

Effet de halo

Perception sélective d’informations allant dans le sens d’une première impression que l’on cherche à confirmer.104

C’est par exemple quand on minimise la gravité des transgressions des personnes dont on a une image positive, quand on cherche avec plus d’application des signes d’intelligence chez ceux qui nous ont renvoyé une bonne première impression, ou quand on juge plus justes les personnes en fonction de leur apparence physique.105 106 107

Effet Pangloss

Raisonner à rebours vers une cause possible parmi d’autres, généralement vers une position qu’on veut prouver.

C’est par exemple penser que le fait qu’on retrouve le nombre d’or (\(\varphi = \frac{1 + \sqrt{5}}{2} \approx 1.61803...\)) très souvent dans la nature est la preuve d’une volonté (un dieu, une force cosmique, etc.). En réalité le nombre d’or se retrouve, car il est est la solution positive à l’équation \(x^2-x-1=0\) et correspond donc à la résolution optimale des contraintes d’encombrement.108